Todos los cursos

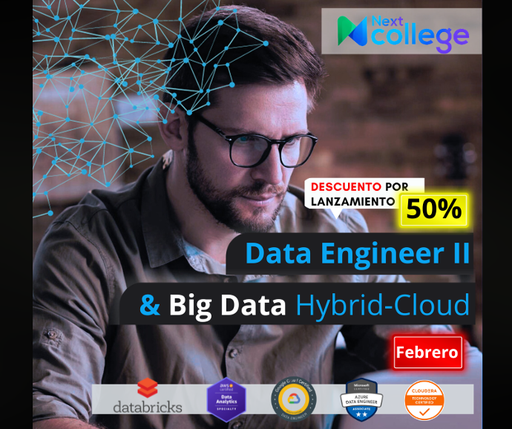

En este programa, el participante adquiere las habilidades que le permiten comprender y desplegar el ecosistema de Hadoop on-premise, es decir en su propia infraestructura, utilizando tecnologías de virtualización como docker y kubernete, e identifica plenamente como dicho ecosistema es desplegado en los principales proveedores cloud: AWS, Azure y GCP, utilizando para ello, los principales servicios auto-gestionados, estando así en la capacidad de satisfacer la demanda creciente del mercado, en relación a contar con profesionales con conocimientos en entornos Híbridos de Big Data (on-presmise & on-cloud), así mismo el participante aprende el lenguaje de programación Python requerido en el contexto de proyectos de Big Data para transformar los datos de formatos crudos (RAW) a formatos estructurados.

Descargar Temario

En este programa, el participante adquiere las habilidades que le permiten comprender y desplegar el ecosistema de Hadoop on-premise, es decir en su propia infraestructura, utilizando tecnologías de virtualización como docker y kubernete, e identifica plenamente como dicho ecosistema es desplegado en los principales proveedores cloud: AWS, Azure y GCP, utilizando para ello, los principales servicios auto-gestionados, estando así en la capacidad de satisfacer la demanda creciente del mercado, en relación a contar con profesionales con conocimientos en entornos Híbridos de Big Data (on-presmise & on-cloud), así mismo el participante aprende el lenguaje de programación Python requerido en el contexto de proyectos de Big Data para transformar los datos de formatos crudos (RAW) a formatos estructurados.

Descargar Temario

En este programa, el participante adquiere las habilidades que le permiten comprender y desplegar el ecosistema de Hadoop on-premise, es decir en su propia infraestructura, utilizando tecnologías de virtualización como docker y kubernete, e identifica plenamente como dicho ecosistema es desplegado en los principales proveedores cloud: AWS, Azure y GCP, utilizando para ello, los principales servicios auto-gestionados, estando así en la capacidad de satisfacer la demanda creciente del mercado, en relación a contar con profesionales con conocimientos en entornos Híbridos de Big Data (on-presmise & on-cloud), así mismo el participante aprende el lenguaje de programación Python requerido en el contexto de proyectos de Big Data para transformar los datos de formatos crudos (RAW) a formatos estructurados.

Descargar Temario

En el programa de Data Engineer II, el participante adquiere las habilidades cognitivas que le permiten entender, diseñar y desarrollar según sea el caso procesos ETL y/o ELT, siendo capaz de identificar los principales frameworks ETL/ELT, formándose en el uso aplicado de Pentaho Data Integration (PDI), la cual forma parte de la suite de analítica provista por la compañía japonesa HITACHI, esto le permitirá desarrollar casos de uso y pruebas de concepto para el tratamiento de datos por streaming en real time y/o near real time, todo ello con el despliegue de clusters con Apache Kafka y Apache Flink.

Descargar Temario

Aprende a implementar soluciones de Cloud Big Data en la nube de Azure, desde la captura de datos hasta su explotación por medio de laboratorios 100% prácticos. En este programa aprenderás a utilizar herramientas de Big Data y Cloud como Azure SQL, Azure CLI, Data Studio, Azure VNets, Cosmos DB, Table Storage, Blob Storage, File Storage, Synapse Analytics, Spark sobre Databricks, HDInsight, Datafactory, Azure Functions, EventHub, Stream Analytics, entre muchas otras herramientas.

Aprende a implementar soluciones de Cloud Big Data en la nube de AWS, desde la captura hasta su explotación y visualización en tiempo real por medio de laboratorios prácticos: Kinesis Firehose, Kinesis Data Stream, DMS, S3, DynamoDB, WCU, Redshift, Lambda, Glue, Databricks, EMR, Hadoop, HIve, Spark, VPC, AWS CLI, RDS, EC2, S3, Cloudwatch, Boto3, Athena, IAM y muchas otras herramientas. Aprenderás a usar todas estas herramientas por medio de patrones de diseño e integración con entornos de Data Lakes.

Aprende a implementar soluciones de Cloud Big Data en nube utilizando el mix tecnológico oficial de Google Cloud Platform, Compute Engine, Cloud Storage, Cloud SQL, Kubernetes Engine, Big Query, Dataflow, entre muchas otras, desde la captura del dato, ingesta, almacenamiento, procesamiento, analítica y explotación del dato, considerando las vistas de seguridad y gobierno cross a nuestras soluciones.

Aprende a definir los planos y arquitecturas de Big Data & Machine Learning de manera profesional sobre entornos ON-PREMISE y CLOUD (Azure, AWS. GCP, Databricks). Aprenderás las vistas arquitectónicas que una solución de Big Data & Machine Learning debe definir para garantizar que el equipo de trabajo realice una correcta implementación y despliegue: vista conceptual, tecnológica, infraestructura, gobierno, seguridad, calidad, devops, modelamiento, entre otras; utilizando los ecosistemas tecnológicos de Hadoop, Azure, AWS, GCP y Databricks. Es un curso ideal para aquellos profesionales que tienen conocimientos conceptuales básicos de Big Data o Machine Learning y aspiran a posiciones de arquitectura o liderazgo técnico.

La Inteligencia Artificial y los métodos de Ciencia de Datos basados en Machine Learning, Deep Learning e Inteligencia Artificial sobre entornos de Big Data están ofreciendo a las empresas nuevas posibilidades en la exploración analítica de sus datos. En este programa aprenderás a implementar diferentes modelos analíticos de Regresión Lineal. Arboles de Decisión, Random Forest, Redes Neuronales, Redes Convolucionales, Redes Recurrentes y métodos de clusterización, aplicados a tablas de bases de datos, imágenes y visión artificial, con técnicas de tuning de código, tensorización de features, calibración de parámetros de modelos, paralelización de código sobre clústers, sizing de infraestructura y despliegue en entornos de Big Data y Cloud sobre CPU y GPU.

Orientado al GeoBussines y al GeoMarketing, con base en la solución de analítica Pentaho Server Pentaho Server, al finalizar el curso estarás en la capacidad de implementar, configurar y administrar una solución Web Mapping del lado del Cliente con Tecnología Open Source, para publicar, de forma correcta y eficiente, información geográfica vectorial y servicios OGC de sus instituciones, sobre el cual podrás montar cuadros de mando, conectándose a un amplia variedad de orígenes de datos. Se emplearán herramientas de desarrollo Open Source y/o gratuitas, sin necesidad de licencias, de manera que el aprendizaje y aplicación esté al alcance de todos, agregando valor a tu profesión y/o negocio.

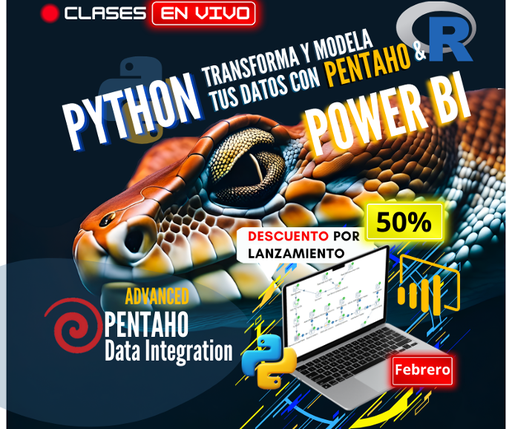

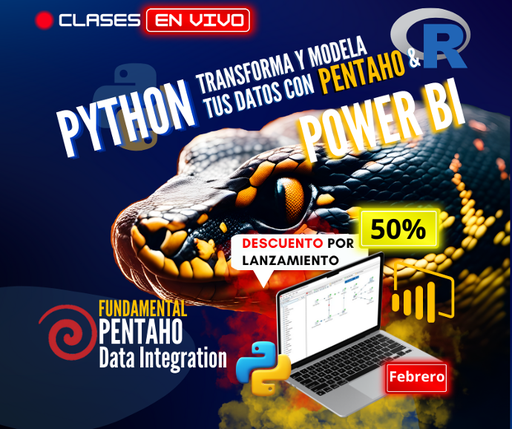

Aprenda a desarrollar ETL’s avanzados con un proyecto integral desarrollado de inicio a fin, donde de forma práctica verás como transparentar la integración de cualquier aplicación a través de Pentaho Data Integration, empleando para ello el consumo de servicios web de tipo SOA, REST, así mismo potenciarás lo aprendido utilizando de forma adecuada la capa de metadatos de la Suite de Pentaho Business Analytics. Todo ello con manejo de versiones a nivel del propio PDI, como con GitHub, aprenderás también el funcionamiento de los componentes avanzados a nivel de Jobs y Transformaciones.

Aprenderás a utilizar Pentaho Data Integration (PDI) mediante ejemplos y ejercicios, y de forma gradual verás cada una de las opciones de Spoon. Trabajarás con los steps más utilizados en los Jobs/Transformations. Aprenderás cómo cargar y actualizar un DW. Ejecutarás las soluciones desde líneas de comandos. Al finalizar el curso podrás crear Jobs/Transformations altamente parametrizables y adaptadas a tu contexto.

Con este curso aprenderás a diseñar tus propios Dashboards basándote en conocimientos acabados sobre el modo en que las personas reaccionan ante los estímulos visuales, el modo en que perciben los datos, colores, formas, realizan comparaciones, etc. Aprenderás qué Charts utilizar de acuerdo al tema analizado, cómo resaltar partes importantes del Chart, utilizar diseños minimalistas, emplear configuraciones avanzadas que incluyan funciones y cálculos matemáticos. Conseguirás que los Charts se adapten lo máximo posible a tus deseos, aplicando ciencia a tus diseños.

Aprenderás a utilizar CTools (CDE, CDF, CCC, CDA) mediante ejemplos y ejercicios, creación de Dashboards de alta calidad, interactivos y con un excelente look&feel, buenas prácticas de desarrollo, utilizando diferentes tipos de Datasources: MDX, SQL, CDA, y configuración de los componentes más utilizados: Charts, Selectors, Gauges, Tables, Pivot, PRD, Popup, Drilldown, Dial Chart, Bullet Chart.

Orientado al GeoBussines y al GeoMarketing, con base en la solución de analítica Pentaho Server Pentaho Server, al finalizar el curso estarás en la capacidad de implementar, configurar y administrar una solución Web Mapping del lado del Cliente con Tecnología Open Source, para publicar, de forma correcta y eficiente, información geográfica vectorial y servicios OGC de sus instituciones, sobre el cual podrás montar cuadros de mando, conectándose a un amplia variedad de orígenes de datos. Se emplearán herramientas de desarrollo Open Source y/o gratuitas, sin necesidad de licencias, de manera que el aprendizaje y aplicación esté al alcance de todos, agregando valor a tu profesión y/o negocio.

Un curso pensado para cubrir aquellos aspectos o zonas grises que no suelen enseñarse y que son considerados los secretos del JS, HTML y el CSS. Descubrirás lo sencillo que es entender y desarrollar estructuras para albergar tus Geo Portales o Geo Dashboards, aprenderás desde los fundamentos, acompañados de tips y/o trucos que te permitirán maquetar, estilar, personalizar y agregar funcionalidad a lo que será la base visual y funcional de tus proyectos empleando javascript, css y html.

Aprenderás a potenciar tus Geo Portales con opciones 3D, utilizarástécnicas avanzadas para subir elementos multimedia (imágenes, videos, etc), siendo capaz de almacenarlos en tu base de datos, así mismo podrás añadir a tus Geo Dashboards paneles con gráficos 3D de alta gama, estarás en capacidad de personalizar tus sidebar y side panels conjugándolos con cards o tarjetas para la manipulación de capas, pudiendo cambiar sus estilos, niveles de transparencia, leyendas, entre otros

Desarrolla tus habilidades en el manejo de bases de datos espaciales y análisis geoespacial a través de este curso. Aprende a utilizar el lenguaje SQL para la gestión eficiente de datos espaciales, administra roles y privilegios, realiza cálculos de rutas óptimas, importa datos provenientes de OSM, y domina técnicas de respaldo y restauración de contenido. Además, obtén una introducción al mundo del web mapping mediante la conexión a Geo Servicios bajo los principios de interoperabilidad.